구글 AI는 어떻게 로봇에게 개의 움직임을 가르치나 ㅣ 가공할 사람의 뇌파로 통제하는 로봇 개 Google’s AI teaches robots how to move by watching dogs ㅣ Brain waves control robot dog's moves

구글 AI는 어떻게 로봇에게 개의 움직임을 가르치나

구글의 인공지능이 로봇에게 개를 보면서 움직이는 법을 가르쳐준다.

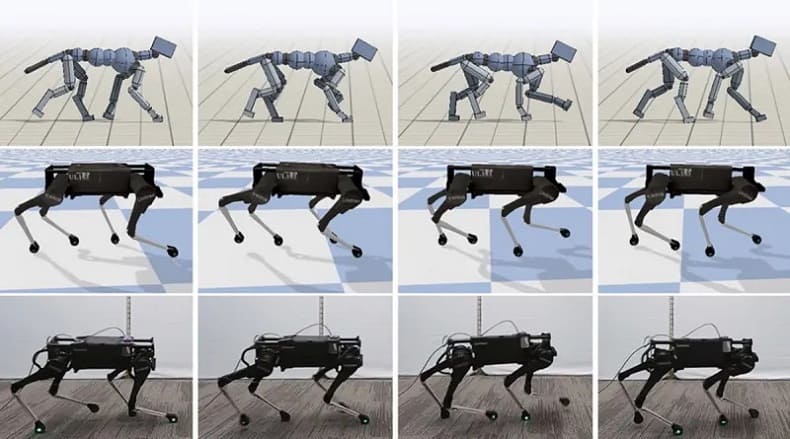

구글의 AI 연구소의 연구원들은 동물들의 움직임으로부터 학습하는 AI 시스템을 개발했다. 그 팀은 실제 개들이 어떻게 움직이는지 연구함으로써 개의 행동을 학습하는 개처럼 생긴 로봇 사족동물을 개발했다.

이 연구는 실제 개의 영상을 보여줌으로써 로봇을 가르치는 것이 매우 어려운 작업이기 때문에 지금까지 우리는 살아있는 생명체의 움직임을 모방함으로써 로봇이 작업을 수행하도록 훈련시킬 수 있었다. 예를 들어 자동차를 만드는 로봇 팔은 원하는 동작을 모방하여 용접을 발견하거나 볼트를 조이는 방법을 배웠다.

이 연구의 목적은 가벼운 발걸음처럼 "유효한 행동"을 효율적이고 자동으로 전달하거나 그들의 근원(훌륭한 개)에서 사족 보행 로봇으로 전환하는 방법을 알아내는 것이었다.

개에 부착된 다양한 센서에서 기록된 움직임의 데이터 세트를 사용함으로써, 연구원들은 네 발 달린 로봇인 라이카고에게 전통적인 방법으로는 배우기 어려운 많은 다양한 움직임을 가르쳤다.

황기철 콘페이퍼 에디터 인플루언서

Ki Chul Hwang Conpaper editor influencer

(Source:

https://techgrabyte.com/google-ai-teaches-robots-move-watching-dogs/)

군인의 뇌파로 통제하는 로봇 개

통상 개들이 "앉아", "가져와" 그리고 "가만 있어"라는 음성 명령에 반응하는 반면, 로봇 개들은 곧 사람의 뇌를 통해 지시를 받을 수도 있다.

이 기술은 5월 11일 제5전투지원대대의 데미안 로빈슨 중사와 제1/15왕립뉴사우스웨일스랜서스의 찬단 라나 중사가 캔버라 주마주라 훈련장에서 로봇에게 집중력을 발휘하도록 명령하면서 입증되었다.

중간 지점에 해당하는 여러 개의 흰색 사각형이 다양한 주파수로 로빈슨 경사의 증강현실 렌즈에서 깜박거렸다.

로빈슨 병장의 머리 뒤에 있는 그래핀 바이오 센서는 그의 시각 피질에서 나오는 뇌파를 감지할 준비가 되어 있었다.

로빈슨 경사가 특정 깜박임에 집중했을 때, 바이오 센서는 상응하는 뇌파를 감지하고 증폭 회로를 신호로 표시했다.

인공지능 디코더는 신호를 명령으로 변환했고, 로봇 개가 이를 따랐다.

로빈슨 병장과 다른 병사는 시드니 공과대학(UTS) 연구진이 개발한 상용 홀로렌즈 러닝 기술을 이용해 고스트 로보틱스 4족 보행 로봇을 조종했다.

"모든 과정을 마스터하는 것은 어렵지 않다. 아주 직관적이다.."라고 로빈슨 병장이 말했다.

로봇은 일반적으로 휴대용 콘솔로 제어되지만 이 경우 작업자의 뇌파가 명령을 시작한다. 이를 통해 작업자는 무기 준비 상태를 유지하거나 다른 작업에 손을 사용할 수 있다.

로빈슨 병장은 4월에 그 프로그램에 참여했고 그 시스템으로 8시간, 2시간의 세션을 했다.

시범을 보이는 동안 로빈슨 병장은 로봇에게 그가 선택할 수 있는 6개의 깜박임 중 하나를 기반으로 미리 결정된 6개의 장소를 방문하도록 명령할 수 있었다.

그는 "로봇을 작동시키기 위해 특별히 생각할 필요는 없지만 깜박임에 초점을 맞출 필요가 있다"고 말했다.

"그것은 시각적 집중력에 더 가깝다."

그 시위의 목적은 군인들이 어떻게 육군이 이 기술을 전술적 환경에 통합시킬 수 있는지에 대해 생각하도록 하는 것이었다.

UTS와 육군 로봇 및 자율 구현 및 조정 사무소(RICO)의 연구원들은 2020년 12월부터 뇌-컴퓨터 인터페이스와 전술적 응용을 탐구하기 위해 함께 일했다.

이 탐사는 국방 혁신 허브, RICO, UTS와 국방 과학기술 그룹 간의 4자 협력이었다.

저명한 UTS의 린친텅 교수와 프란체스카 이아코피 교수는 뇌-컴퓨터 인터페이스 분야에서 몇 가지 돌파구를 마련했다.

린 교수는 조작자의 뇌에서 더 명확한 신호를 얻기 위해 신체와 환경에서 발생하는 소음을 최소화하는 방법을 알아냈다.

또 다른 발전은 디코더가 정해진 기간 내에 전달할 수 있는 명령어의 수를 증가시키는 것이었다.

린 교수는 "우리는 9가지 다른 종류의 명령을 가지고 있으며 운영자는 그 기간 내에 그 9가지 명령 중 하나를 선택할 수 있다"고 말했다.

아이아코피 교수는 최첨단 그래핀 소재를 통해 뇌파를 감지하는 데 사용되는 구형 바이오센서 대체품을 개발, 부식, 내구성, 피부 접촉 저항 등의 문제를 극복했다.

아이아코피 교수는 "생물학적으로 매우 적합하고 전도성이 뛰어난 그래핀의 최고 성능을 실리콘의 최고 기술과 결합할 수 있게 돼 바이오센서가 매우 탄력적이고 견고하게 사용할 수 있게 됐다"고 말했다.

국방은 국방 혁신 허브를 통해 UTS에 120만 달러의 연구 자금을 제공했다.

황기철 콘페이퍼 에디터 인플루언서

Ki Chul Hwang Conpaper editor influencer

(Source:

https://news.defence.gov.au/technology/brain-waves-control-robot-dogs-moves)

- [코레일] "기차로 여행 떠나면...할인에⋯

- 서울시, '전기차 무선충전' ...정류장에⋯

- 골재 품질검사, 품질관리 전문기관 통⋯

- 세계 최고의 몸값 축구선수들...손흥민⋯

- 윤석열의 적은 내부에 있다...왜 청산하⋯

kcontents