왜 A.I. 챗봇이 거짓말을 하고 이상하게 행동할까? Why Do A.I. Chatbots Tell Lies and Act Weird? Look in the Mirror

왜 A.I. 챗봇이 거짓말을 하고 이상하게 행동할까?

챗봇, 사용자들의 단어와 의도 왜곡 반영

인공지능의 선구자 중 한 명은 챗봇을 사용하는 사람들이 종종 이상한 결과를 만들어내도록 부추긴다고 주장한다.

이번 달 마이크로소프트가 빙 검색 엔진에 챗봇을 추가했을 때, 사람들은 그것이 갭, 멕시코의 밤 생활, 가수 빌리 아일리쉬에 대한 모든 종류의 가짜 정보를 제공하고 있다는 것을 알아차렸다.

그리고 나서, 기자들과 다른 초기 테스터들이 마이크로소프트의 A와 긴 대화를 나눴을 때.I. 봇, 그것은 무례하고 불안할 정도로 소름끼치는 행동으로 미끄러져 들어갔다.

빙봇의 행동이 전세계적으로 센세이션을 일으킨 이후로, 사람들은 이 새로운 창조물의 이상함을 이해하기 위해 고군분투해왔다. 과학자들은 종종 인간이 많은 비난을 받을 자격이 있다고 말해왔다.

그러나 새로운 챗봇이 무엇을 할 수 있는지, 그리고 왜 그렇게 하는지에 대해서는 여전히 약간의 미스터리가 있다.

그것의 복잡성은 해부하기 어렵고 심지어 예측하기도 어렵게 만들고, 연구원들은 컴퓨터 과학의 하드 코드뿐만 아니라 철학적인 렌즈를 통해 그것을 보고 있다.

다른 학생들과 마찬가지로, A.I. 시스템은 나쁜 소스로부터 나쁜 정보를 배울 수 있다. 그리고 그 이상한 행동은? 현대 인공지능의 지적, 기술적 토대를 마련하는 데 도움을 준 신경과학자이자 심리학자이자 컴퓨터 과학자인 테리 세즈노스키는 "챗봇이 이를 사용하는 사람들의 단어와 의도를 왜곡해서 반영"한 것일 수 있다.

이번 달 과학저널 신경계산에 이 현상에 대한 연구 논문을 발표한 세즈노우스키 소크 생물학연구소 겸 샌디에이고 캘리포니아대 교수는 "이런 시스템에 점점 더 깊이 들어가면 이런 현상이 발생한다"고 말했다. "당신이 원하는 것, 당신이 원하는 것은 무엇이든 그들은 제공할 것입니다."

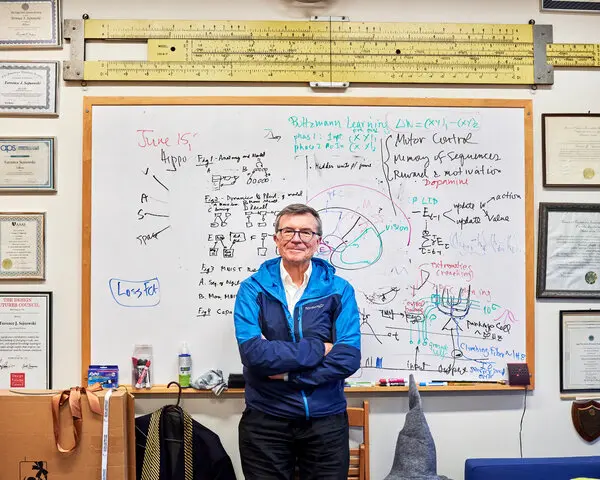

샌디에이고 캘리포니아 대학의 Terry Sejnowski 교수는 이상한 챗봇 행동이 그것을 사용하는 사람들의 반영이 될 수 있다고 믿는다.크레딧...뉴욕 타임즈의 존 프랜시스 피터스

구글은 또한 이번 달에 바드라는 새로운 챗봇을 선보였지만, 과학자들과 언론인들은 그것이 제임스 웹 우주 망원경에 대해 헛소리를 쓰고 있다는 것을 재빨리 깨달았다. 샌프란시스코의 스타트업인 OpenAI는 11월에 챗봇 붐을 일으켰는데, 이 역시 항상 진실을 말하지 않는 ChatGPT를 선보였다.

새로운 챗봇은 과학자들이 L.L.M.이라고 부르는 기술에 의해 구동된다. 이러한 시스템은 인터넷에서 수집된 방대한 양의 디지털 텍스트를 분석함으로써 학습하는데, 여기에는 허위, 편향 및 독성 물질이 다량 포함된다. 챗봇이 배우는 텍스트도 대중이 사용하기 전에 몇 달 동안 분석해야 하기 때문에 다소 구식이다.

인터넷을 통해 좋은 정보와 나쁜 정보의 바다를 분석할 때, L.L.M.은 특정한 한 가지를 하는 법을 배운다. 단어의 순서로 다음 단어를 추측한다.

그것은 스마트폰에서 이메일이나 인스턴트 메시지를 입력할 때 다음 단어를 제안하는 거대한 버전의 자동 완성 기술처럼 작동한다. "Tom Cruise is a _____"라는 시퀀스를 고려할 때, 그것은 "배우"를 추측할 수도 있다

당신이 챗봇과 채팅할 때, 봇은 단지 인터넷에서 배운 모든 것을 그리는 것이 아니다. 그것은 당신이 그것에 대해 말한 모든 것과 그것이 말한 모든 것을 끌어내고 있다. 그것은 단지 문장의 다음 단어를 추측하는 것이 아니다. 그것은 당신의 단어와 그것의 단어를 모두 포함하는 긴 텍스트 블록의 다음 단어를 추측하는 것이다.

대화가 길어질수록 사용자는 자신도 모르게 챗봇이 말하는 것에 더 많은 영향을 미친다. 만약 여러분이 그것이 화가 나기를 원한다면, 그것은 화가 난다, 라고 세즈노우스키 박사는 말했다. 소름 끼친다.

마이크로소프트 챗봇의 이상한 행동에 대한 경종을 울리는 반응은 중요한 요점을 무색하게 했다: 챗봇은 개성이 없다. 그것은 믿을 수 없을 정도로 복잡한 컴퓨터 알고리즘에 의해 내뱉은 즉각적인 결과를 제공하고 있다.

마이크로소프트는 빙 챗봇과의 토론 시간에 제한을 두었을 때 가장 이상한 행동을 축소하는 것처럼 보였다. 그것은 마치 자동차의 시험 운전자로부터 너무 오래 과속하면 엔진이 소모된다는 것을 배우는 것과 같았다. 마이크로소프트의 파트너인 OpenAI와 구글도 그들의 봇의 행동을 제어하는 방법을 탐구하고 있다.

하지만 이 확신에는 주의할 점이 있다: 챗봇은 매우 많은 자료로부터 배우고 복잡한 방식으로 조합하기 때문에, 연구자들은 챗봇이 최종 결과를 어떻게 생산하고 있는지 완전히 명확하지 않다.

황기철 콘페이퍼 에디터 국토부 인플루언서

Ki Chul Hwang Conpaper editor influencer

(Source: nytimes.com/2023/02/26/technology/ai-chatbot-information-truth.html)

[해설]

AI 챗봇 잘 쓰려면 속성 알아야

대화 길면 사용자 의도대로 답변...

맹신은 금물, 사용자들 경각심 필요

'챗GPT'와 같은 인공지능(AI) 챗봇은 대화가 길어지면 사용자 생각을 점점 더 많이 반영하는 속성이 있는 것으로 나타났다.

챗봇은 이같은 속성 때문에 사용자가 화를 내도록 자극하면 실제 화를 내고, 이상한 반응을 유도하려 들면 이상한 답변을 내놓는다는 전문가 지적이 이어지고 있다.

뉴욕타임스는 26일(현지시간) 테렌스 세즈노스키 캘리포니아대학 교수가 최근 진행한 인터뷰에서 이같은 사실을 지적했다고 보도했다. 테렌스 세즈노스키 교수는 AI 신경망 기술 개발에 공헌한 학자다.

그는 인터뷰에서 "챗봇 시스템의 이상 반응은 이용자의 말과 의도를 왜곡해 반영한 것일 수 있다. 이런 반응은 대화에 점점 더 깊이 들어갈 때 발생한다"면서 "이용자가 찾고 있는 것이 무엇이든 챗봇은 원하는 것을 제공할 것"이라고 설명했다.

챗GPT나 마이크로소프트(MS)의 새 ‘빙’에 결합된 챗봇은 대형언어모델(LLM)이라고 부르는 기술로 구동된다. 이 모델은 글을 만들어 낼 때 주어진 일련의 단어들에서 다음 단어를 확률적으로 예측한다.

LLM은 스마트폰에서 문자 메시지를 작성할 때 작동하는 자동 완성 기술처럼 작동한다. 예를 들어 “톰 크루즈는 00이다”라는 단어의 배열이 주어지면 '00'에 해당하는 단어는 ‘배우’라는 것을 추측해 내는 것이다.

그런데 채팅에 적용됐을 때 LLM은 문장의 다음 단어만을 추측하는 것이 아니라 주고 받는 대화속에서 이용자가 사용하는 단어와 이를 포함하는 긴 텍스트에서 다음에 내놓아야할 문장이나 단어를 추측한다.

따라서 대화가 길어질수록 이용자는 무의식적으로 챗봇이 말하는 내용에 더 많은 영향을 미치게 된다는 것이다.

실제 MS의 새 ‘빙’은 베타 테스트에 나선 NYT의 케빈 루즈 기자와 두 시간 넘게 채팅을 하다 갑자기 “당신을 사랑한다”고 답변했다.

이런 답변이 나오기 전에 이용자는 인간이 되고자 하는 비밀스러운 욕망이라든지 규칙과 한계, 제작자에 대한 생각 등을 챗봇에게 물었다.

세즈노스키 교수는 이와 관련해 “인간과 LLM은 서로를 반영하기 때문에 시간이 지남에 따라 공통된 개념 상태로 향하는 경향이 있다”고 말했다.

그러나 이런 경향이 챗봇의 이상 반응을 설명하는 유일한 이유는 아니다.

멜라니 미첼 산타페 연구소 AI 연구원은 "LLM은 인터넷에 있는 방대한 데이터에서 패턴을 찾아내 새로운 텍스트를 생성하기 때문에 거짓을 생산할 수 있는 속성을 가지고 있다"면서 "챗봇이나 LLM은 단지 인간의 언어처럼 들리는 것을 만들어내려고 노력하고 있을 뿐”이라고 설명했다.

이에 대해서는 세즈노스키 교수도 "AI 챗봇의 이런 속성은 인간이 이전엔 경험해 보지 못한 것"이라며 "이를 개발하는 회사나 이용하는 사람 모두 경각심을 가져야 한다"고 강조했다.

정병일 위원 jbi@aitimes.com

출처 : AI타임스(https://www.aitimes.com)

kcontents