포스텍, 전 영역 동시 인식 고정형 라이다 센서 개발 ㅣ 카이스트, 상상만으로 원하는 방향 사용가능 로봇 팔 뇌-기계 인터페이스 개발

Construction, Science, IT, Energy and all other issues

Search for useful information through the top search bar on blog!

건설,과학,IT, 에너지 외 국내외 실시간 종합 관심 이슈 발행

[10만이 넘는 풍부한 데이터베이스]

블로그 맨 위 상단 검색창 통해 유용한 정보를 검색해 보세요!

목차

#1 포스텍, 360° 볼 수 있는 자율주행 자동차의 ‘눈’ 개발

#2 카이스트, 상상만으로 원하는 방향으로 사용가능

로봇 팔 뇌-기계 인터페이스 개발

#1 기계·화공 노준석 교수팀,

360° 볼 수 있는 자율주행 자동차의 ‘눈’

빛을 쏴서 물체를 인식하는 라이다(LiDAR) 센서는 자율주행 자동차가 주변 물체와의 거리를 파악하고 주행 속도나 방향을 판단할 수 있도록 돕는 ‘눈’ 역할을 한다. 예측 불가능한 도로 상황에 민감하게 대응하기 위해선 정면뿐만 아니라 옆이나 뒤를 함께 살펴야 하는데, 현재는 회전하는 라이다 센서를 사용하기 때문에 전·후방을 동시에 파악할 수는 없었다.

카이스트 기계공학과·화학공학과 노준석 교수·기계공학과 통합과정 김경태·김예슬·윤주영 씨, 성균관대 생명물리학과 김인기 교수 연구팀은 공동연구를 통해 360° 전 영역을 볼 수 있는 고정형 라이다 센서를 개발했다.

- "세계 최초 미세 바늘까지 잡을 수 있는 코끼리 코 로봇 손 개발" 한국기계연구원

- ‘사람 같은’ 전자피부 로봇 VIDEO: Touchlab to begin piloting its robotic skin sensors in a hospital setting

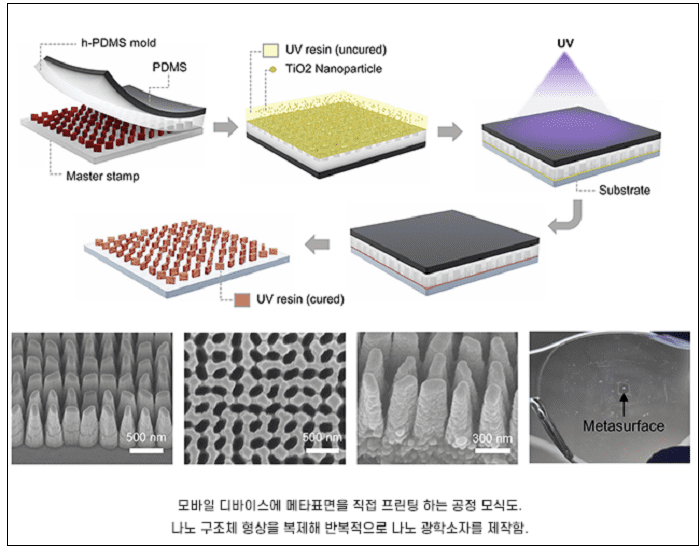

이 센서는 머리카락 두께 1,000분의 1 크기에 불과한 초박형 평면 광학소자인 메타표면으로 만들어져, 초소형 라이다 센서를 구현할 수 있는 원천 기술로 더욱 눈길을 끈다.

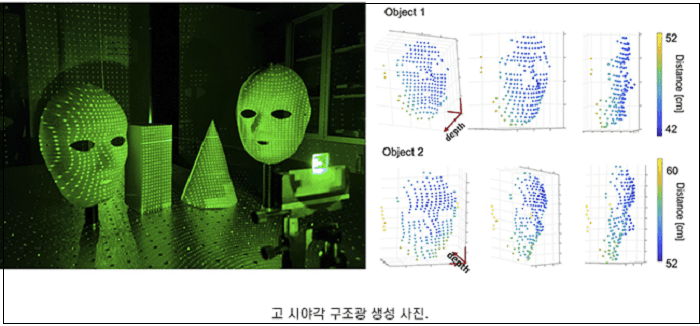

메타표면을 이용하면 라이다의 시야각을 대폭 넓힐 수 있을 뿐만 아니라 물체를 입체적으로 인식할 수 있다. 연구팀은 메타표면을 구성하는 나노 구조체의 설계와 주기적 배열 방식을 조절해 라이다 센서의 시야 각도를 360°까지 넓히는 데 성공했다.

메타표면에서 방사된 10,000개 이상의 점 구름(빛)이 물체에 조사되고, 조사된 점 패턴을 카메라로 촬영하면 360° 영역에 있는 물체 정보를 3차원(3D)으로 파악할 수 있다.

이러한 방식의 라이다 센서는 아이폰 얼굴인식 기능(Face ID)에도 사용되고 있다. 아이폰은 점 구름을 만들기 위해 점 생성기(Dot projector) 장치를 사용하지만, 점 패턴의 균일도와 시야각이 제한적인 데다가 부피가 크다는 한계가 있었다.

이번 기술은 핸드폰, 가상현실(VR)·증강현실(AR) 안경, 무인 로봇이 주변 환경의 3D 정보를 인식하는 기술을 나노 광학 소재로 구현했다는 데 의의가 있다. 나노 임프린트 기술을 활용, 안경과 같은 곡면이나 유연 기판과 같은 다양한 표면에도 손쉽게 프린팅할 수 있어 미래 디스플레이의 핵심으로 알려진 AR 글래스 등에 적용하기에 용이하다.

노준석 교수는 “기존 메타표면 장치보다 고도화된 기술을 개발, 모든 각도에서 빛의 전파를 조절할 수 있음을 입증했다“며 “이는 초소형·고(高) 시야각 깊이 인식 센서 플랫폼을 구현할 수 있는 원천 기술이 될 것”이라고 말했다.

한편, 국제 학술지 ‘네이처 커뮤니케이션스(Nature Communications)’에 최근 게재된 이 연구는 삼성미래기술육성센터의 지원을 받아 이뤄졌다.

카이스트 홍보실

#2 상상만으로 원하는 방향으로 사용가능한

로봇 팔 뇌-기계 인터페이스 개발

우리 대학 뇌인지과학과 정재승 교수 연구팀이 인간의 뇌 신호를 해독해 장기간의 훈련 없이 생각만으로 로봇 팔을 원하는 방향으로 제어하는 뇌-기계 인터페이스 시스템을 개발했다고 24일 밝혔다.

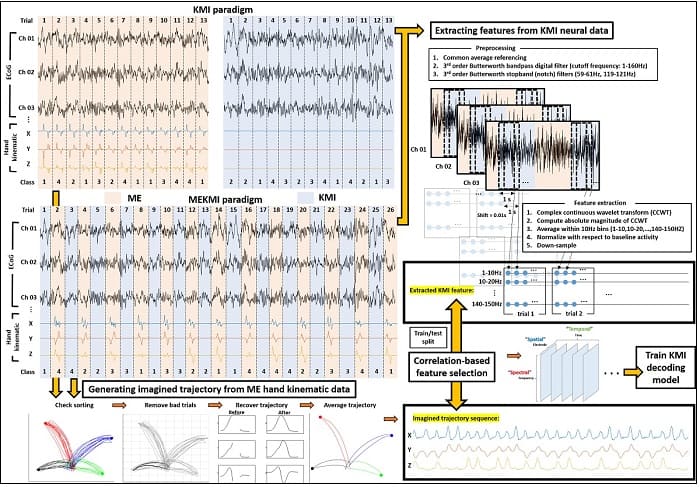

서울의대 신경외과 정천기 교수 연구팀과 공동연구로 진행된 이번 연구에서 정 교수 연구팀은 뇌전증 환자를 대상으로 팔을 뻗는 동작을 상상할 때 관측되는 대뇌 피질 신호를 분석해 환자가 의도한 팔 움직임을 예측하는 팔 동작 방향 상상 뇌 신호 디코딩 기술을 개발했다. 이러한 디코딩 기술은 실제 움직임이나 복잡한 운동 상상이 필요하지 않기 때문에 운동장애를 겪는 환자가 장기간 훈련 없이도 자연스럽고 쉽게 로봇 팔을 제어할 수 있어 앞으로 다양한 의료기기에 폭넓게 적용되리라 기대된다.

바이오및뇌공학과 장상진 박사과정이 제1 저자로 참여한 이번 연구는 뇌공학 분야의 세계적인 국제 학술지 `저널 오브 뉴럴 엔지니어링 (Journal of Neural Engineering)' 9월 19권 5호에 출판됐다. (논문명 : Decoding trajectories of imagined hand movement using electrocorticograms for brain-machine interface).

뇌-기계 인터페이스는 인간이 생각만으로 기계를 제어할 수 있는 기술로, 팔을 움직이는 데 장애가 있거나 절단된 환자가 로봇 팔을 제어해 일상에 필요한 팔 동작을 회복할 수 있는 보조기술로 크게 주목받고 있다.

로봇 팔 제어를 위한 뇌-기계 인터페이스를 구현하기 위해서는 인간이 팔을 움직일 때 뇌에서 발생하는 전기신호를 측정하고 기계학습 등 다양한 인공지능 분석기법으로 뇌 신호를 해독해 의도한 움직임을 뇌 신호로부터 예측할 수 있는 디코딩 기술이 필요하다.

그러나 상지 절단 등으로 운동장애를 겪는 환자는 팔을 실제로 움직이기 어려우므로, 상상만으로 로봇 팔의 방향을 지시할 수 있는 인터페이스가 절실히 요구된다. 뇌 신호 디코딩 기술은 팔의 실제 움직임이 아닌 상상 뇌 신호에서 어느 방향으로 사용자가 상상했는지 예측할 수 있어야 하는데, 상상 뇌 신호는 실제 움직임 뇌 신호보다 신호대잡음비(signal to noise ratio)가 현저히 낮아 팔의 정확한 방향을 예측하기 어려운 문제점이 오랫동안 난제였다. 이러한 문제점을 극복하고자 기존 연구들에서는 팔을 움직이기 위해 신호대잡음비가 더 높은 다른 신체 동작을 상상하는 방법을 시도했으나, 의도하고자 하는 팔 뻗기와 인지적 동작 간의 부자연스러운 괴리로 인해 사용자가 장기간 훈련해야 하는 불편함을 초래했다.

따라서 팔을 뻗는 상상을 할 때 어느 방향으로 뻗었는지 예측하는 디코딩 기술은 정확도가 떨어지고 환자가 사용법을 습득하기 어려운 문제점이 있다. 이 문제가 오랫동안 뇌-기계 인터페이스 분야에서 해결해야 할 난제였다.

- 물건을 쉽게 잡고 잡을 수 있는 가성비 좋은 로봇 손 Anthropomorphic Clone Hand grasping different objects

- 허리케인을 경험 할 수 있는 세계 최초 태풍 시뮬레이터 공개 VIDEO: World's first public STORM SIMULATOR that lets people experience a category II hurricane...

연구팀은 문제 해결을 위해 사용자의 자연스러운 팔 동작 상상을 공간해상도가 우수한 대뇌 피질 신호(electrocorticogram)로 측정하고, 변분 베이지안 최소제곱(variational Bayesian least square) 기계학습 기법을 활용해 직접 측정이 어려운 팔 동작의 방향 정보를 계산할 수 있는 디코딩 기술을 처음으로 개발했다.

연구팀의 팔 동작 상상 신호 분석기술은 운동피질을 비롯한 특정 대뇌 영역에 국한되지 않아, 사용자마다 상이할 수 있는 상상 신호와 대뇌 영역 특성을 맞춤형으로 학습해 최적의 계산모델 파라미터 결괏값을 출력할 수 있다.

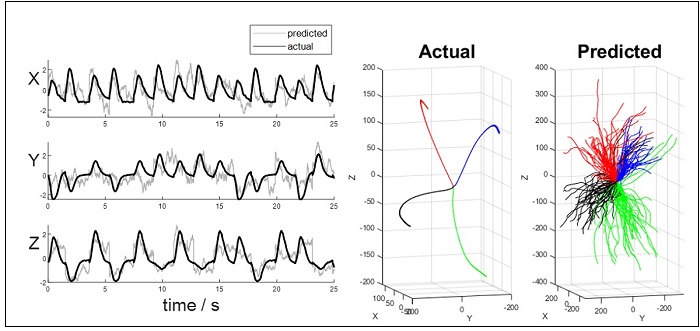

연구팀은 대뇌 피질 신호 디코딩을 통해 환자가 상상한 팔 뻗기 방향을 최대 80% 이상의 정확도로 예측할 수 있음을 확인했다.

나아가 계산모델을 분석함으로써 방향 상상에 중요한 대뇌의 시공간적 특성을 밝혔고, 상상하는 인지적 과정이 팔을 실제로 뻗는 과정에 근접할수록 방향 예측정확도가 상당히 더 높아질 수 있음을 연구팀은 확인했다.

연구팀은 지난 2월 인공지능과 유전자 알고리즘 기반 고 정확도 로봇 팔 제어 뇌-기계 인터페이스 선행 연구 결과를 세계적인 학술지 `어플라이드 소프트 컴퓨팅(Applied soft computing)'에 발표한 바 있다. 이번 후속 연구는 그에 기반해 계산 알고리즘 간소화, 로봇 팔 구동 테스트, 환자의 상상 전략 개선 등 실전에 근접한 사용환경을 조성해 실제로 로봇 팔을 구동하고 의도한 방향으로 로봇 팔이 이동하는지 테스트를 진행했고, 네 가지 방향에 대한 의도를 읽어 정확하게 목표물에 도달하는 시연에 성공했다.

뇌인지과학과 정재승 교수

연구팀이 개발한 팔 동작 방향 상상 뇌 신호 분석기술은 향후 사지마비 환자를 비롯한 운동장애를 겪는 환자를 대상으로 로봇 팔을 제어할 수 있는 뇌-기계 인터페이스 정확도 향상, 효율성 개선 등에 이바지할 수 있을 것으로 기대된다.

연구책임자 정재승 교수는 "장애인마다 상이한 뇌 신호를 맞춤형으로 분석해 장기간 훈련을 받지 않더라도 로봇 팔을 제어할 수 있는 기술은 혁신적인 결과이며, 이번 기술은 향후 의수를 대신할 로봇팔을 상용화하는 데에도 크게 기여할 것으로 기대된다ˮ고 말했다.

포스텍 홍보실

케이콘텐츠