구글의 AI는 만능?...홍수 예측에 작곡까지 VIDEO: Google Introduces New AI-Powered Text-to-Video, Language, and Writing Tools

Construction, Science, IT, Energy and all other issues

Search for useful information through the top search bar on blog!

건설,과학,IT, 에너지 외 국내외 실시간 종합 관심 이슈 발행

[10만이 넘는 풍부한 데이터베이스]

블로그 맨 위 상단 검색창 통해 유용한 정보를 검색해 보세요!

홍수 예측하고, AI가 작곡과 소설 창작까지

구글의 AI는 이런 것까지 한다

말만 하면 AI(인공지능)가 동영상을 만들어주고, 동영상에 삽입될 음악을 창작해주며, 이와 관련한 소설을 작성한다. 방언만 사용하는 아프리카 소수 부족과 번역 앱을 통해 의사소통을 한다. 비가 오면 어느 강에서 홍수가 날지 미리 알 수 있다.

- 4족 보행 로봇이 2족 보행으로 바뀔 때 VIDEO: Multi-Modal Legged Locomotion Framework with Automated Residual Reinforcement Learning

- '버려지는 나무가 수소로 다시 태어났다" 카이스트

이는 구글이 AI를 통해 만드는 미래의 모습이다. 2일(현지시각) 세계 최대 검색 기업 구글이 미 뉴욕 구글 오피스에서 ‘AI 연례 컨퍼런스’를 열고 강화된 AI 기능을 대거 공개했다. 실생활에 하나둘씩 적용되는 AI 기술의 활용 범위를 대폭 확장한 것이 특징이다. 전설적인 프로그래머로 알려진 구글의 제프 딘 부사장 겸 시니어펠로우는 “AI의 발전이 지금 당장은 매우 빠르게 느껴질 수 있지만 사실은 오랜 발전 과정에서 나온 것”이라며 “신경망 아키텍처, 머신러닝 알고리즘, 머신러닝 하드웨어의 발전은 AI가 실제 삶 속 문제를 해결하는 데 도움이 되고 있다”고 했다.

말만 하면 동영상에 음악, 소설, 코딩까지

구글은 이날 최근 테크 업계의 가장 큰 화두인 ‘제너레이티브(생성) AI’ 기술을 대거 공개했다. 사람이 문자로 명령을 입력하면 AI가 이미지나 동영상, 음악 등을 창작해 내놓는 것이다.

구글은 올 5월 문자-이미지 변환 AI 모델인 이매젠을 공개한 데 이어, 이날 텍스트 명령으로 고해상도 영상을 만들어내는 ‘이매젠 비디오’와 ‘페나키’ 모델을 공개했다. 구글의 모델로 만든 동영상은 메타 등 다른 업체가 만든 문자-동영상 변환 AI 모델보다 고화질이고, 재생 시간이 더 길다. 이날 구글은 여러 개의 영상을 보여줬는데 그 중 하나인 45초짜리 동영상에서는 나뭇가지에 걸린 파란색 풍선이 보이다가 카메라가 왼쪽으로 이동하며 동물원 속 기린의 모습을 보여준다. TV나 영화에서 보는 화질에는 미치지 못하지만 나름 자연스럽다.

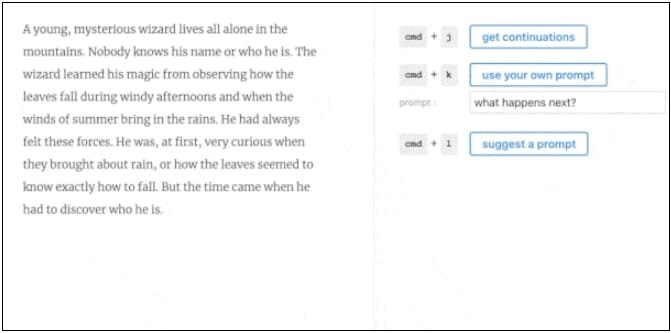

구글은 또 6초 분량의 음성만 있으면 이를 기반으로 사람의 목소리를 재현하고, 피아노 음악까지 만들어주는 ‘오디오LM 기술’, 구글의 AI 언어모델인 람다를 활용해 짧은 문장을 던지면 AI가 다음 문장을 만들어내는 ‘워드크래프트’도 선보였다. 구글은 “워드크래프트는 전문 작가들과 협업하고 있다”고 했다.

구글은 또 사람이 언어로 명령하면, AI가 스스로 코딩을 하는 기능도 공개했다. 일반 코드뿐만 아니라 로봇 동작을 제어할 수 있는 코드도 능숙하게 짜낸다.

공익 위한 AI 기술

AI는 사람 대신 무언가를 창작하는 데 그치지 않는다. 구글은 AI 기술을 활용해 재해를 예측하는 공익적 AI 기술도 공개했다. 대표적인 것이 ‘플러드허브(FloodHub)’라는 홍수 예측 시스템이다. 머신러닝을 통해 학습된 AI가 현재 기상상황과 강의 수위를 예상해 홍수 경보를 내린다. 플러드허브에서는 현재 전 세계 어디서 홍수 가능성이 있는지를 한눈에 보여준다.

구글은 2017년부터 이 AI 기능을 출시했는데, 이번에 이를 강화하고, 브라질·콜롬비아·스리랑카·가나·나이지리아 등 18개 국가에도 적용한다고 밝혔다. 구글은 “홍수 조기 경보 시스템을 통해 사망 사고의 43%, 경제적 피해의 35~50%를 예방할 수 있다”고 했다.

- 특허청, 2022년 특허기술상 수상자 선정...세종대왕상에 효성티앤씨 김천기 연구원

- 아인슈타인의 뇌는 지금 어디에 있을까? VIDEO: Where is Einstein's brain

구글은 또 위성 이미지를 통해 학습한 AI가 실시간으로 산불을 추적하고, 산불이 어떻게 전개될 지 예상하는 시스템도 공개했다. 현재 이 AI 기능은 호주와 미국, 캐나다, 멕시코에서 운용하고 있다.

번역앱을 가진 구글은 AI 언어 모델을 통해 기존에는 통·번역이 불가능했던 언어 1000개도 지원하겠다는 ‘1000개 언어 이니셔티브’ 프로젝트도 발표했다. 현재 지구상엔 7000여개의 언어가 있는데, 온라인에서 통용되는 언어는 몇 개 안된다. 구글은 기존의 웹 텍스트를 기반으로 AI를 학습하는 모델은 다양한 언어를 포착하지 못한다는 한계를 인지하고, 새로운 방식의 언어 지원 AI 모델을 구축했다.

400개 언어로 학습한 유니버설 스피치 모델(USM)을 개발했고, 직접 남아시아 지역 방언과 오디오 샘플을 수집 중이다. 얀 스칼퀵 구글 선임연구원은 “이를 통해 전 세계 수십억명이 자신의 모국어로 유튜브, 구글 번역 등의 서비스를 쉽게 이용할 수 있게 할 것”이라고 했다.

구글은 앞으로 AI 기술을 지속 발전시켜나갈 예정이다. AI가 초음파 장치의 출력을 읽고 분석해 임신 여부를 확인해주는 기능, 자동 망막 질환 평가 도구(ARDA)를 통해 당뇨병성 망막병증을 검사하는 기능, 스마트폰만 있으면 누구나 의료 서비스에 쉽게 접근할 수 있도록 하는 기능을 연구 중이다. 제프 딘 구글 부사장 겸 시니어펠로우는 “앞으로 AI를 통해 훨씬 더 많은 것이 가능해질 것”이라고 말했다.

실리콘밸리=김성민 특파원 조선일보

Google’s Video AI: Outrageously Good!

KCONTENTS