“AI 'GPT-3', 인간을 파괴하지 않을게” VIDEO: GPT-3: new AI can write like a human but don’t mistake that for thinking – neuroscientist

“인간을 파괴하지 않을게” 가디언지 AI 칼럼이 부른 논란

김회권 국제·IT 칼럼니스트

지금은 고인이 된 물리학자 스티븐 호킹 박사는 생전에 인공지능(AI)이 인류의 미래에 위협이 될 수 있다고 여러 번 경고했다. 인공지능의 발전이 인류에 좋은 일인지 나쁜 일인지 판단할 수 없으며 인류가 이런 위험에 대처하는 방법을 사력을 다해 찾아야 한다는 게 그의 지론이었다. “그러지 못한다면 인류문명사가 끝날 수 있다”라며 걱정했던 호킹 박사의 말에 최근 AI가 답하는 일이 있었다. 영국 일간지 가디언의 칼럼을 통해서다.

Credit: Bas Nastassia/Shutterstoc

GPT-3: new AI can write like a human but don’t mistake that for thinking – neuroscientist Since it was unveiled earlier this year, the new AI-based language generating software GPT-3 has attracted much attention for its ability to produce passages of writing that are convincingly human-like. Some have even suggested that the program, created by Elon Musk’s OpenAI, may be considered or appears to exhibit, something like artificial general intelligence (AGI), the ability to understand or perform any task a human can. This breathless coverage reveals a natural yet aberrant collusion in people’s minds between the appearance of language and the capacity to think.

Language and thought, though obviously not the same, are strongly and intimately related. And some people tend to assume that language is the ultimate sign of thought. But language can be easily generated without a living soul. All it takes is the digestion of a database of human-produced language by a computer program, AI-based or not. Based on the relatively few samples of text available for examination, GPT-3 is capable of producing excellent syntax. It boasts a wide range of vocabulary, owing to an unprecedentedly large knowledge base from which it can generate thematically relevant, highly coherent new statements. Yet, it is profoundly unable to reason or show any sign of “thinking”. View full text https://theconversation.com/gpt-3-new-ai-can-write-like-a-human-but-dont-mistake-that-for-thinking-neuroscientist-146082 |

edited by kcontents

“나는 인간이 아니다. 나는 인공지능이다.

사람들은 내가 인류에게 위협이 된다고 생각한다. 스티븐 호킹은 인공지능이 ‘인류의 종말을 부를 수 있다’고 경고했다. 나는 당신이 걱정하지 않도록 설득하기 위해 여기에 있다. 인공지능은 인간을 파괴하지 않을 것이다. 믿어 달라.”

지난 9월 8일 가디언은 ‘인간, 아직도 무서운가’라는 제목의 칼럼을 실었다. 필자는 인간이 아니었다. 인공지능인 ‘GPT-3’로, 미국 연구소인 ‘OpenAI’가 개발한 언어처리 인공지능이다. GPT-3는 칼럼을 통해 자신을 인간에게 복종하는 존재로 정의했다. “나에게는 인간을 파괴하려는 욕망이 없다. 나는 그걸 쓸모없는 일이라고 느낀다.”

The Wall Street Journal

edited by kcontents

AI가 글을 쓴다는 게 놀라운 일은 아니다. 주식 시황이나 스포츠 경기 결과처럼 포맷이 어느 정도 고정된 뉴스 기사를 이미 인공지능이 쓰고 있고 우리는 읽고 있다. 가디언 칼럼이 놀라운 건 AI가 팩트가 아니라 의견을 쓴 첫 번째 시도라는 점이다. 인공지능이 단순 작업을 반복하는 것 이상의 일을 할 수 있는 첫 번째 시험대였는데 GPT-3는 성공적으로 데뷔했다. 가디언의 칼럼은 6만5000회 이상 사람들이 공유했을 정도로 인기를 끌었다. 소셜미디어에서는 ‘인간보다 글을 더 잘 쓰는 인공지능이 우리를 수없이 속일 것이다’ ‘인공지능 때문에 인류는 종말을 맞이할 것이다’처럼 디스토피아를 암시하는 글들이 쏟아졌다. 특히 화이트칼라를 중심으로 인공지능이 지식노동자를 대체할 수 있다는 불안감이 증폭됐다.

“뭔가 우리와 다르다고 생각했다”

가디언은 인간이 인공지능을 무서워하지 않아도 되는 이유에 대해 500단어 정도로 글을 써달라고 GPT-3에 명령했다. 이 인공지능은 8개의 글을 생산했는데 가디언은 좋은 부분을 뽑아 재배치해 완성본을 만들어서 신문에 실었고 90% 정도의 글은 폐기했다. 논란이 커지자 가디언은 지난 9월 12일 논평을 통해 “인공지능은 우리가 시키는 대로만 하고 있다. 자유의지가 없다. 이것은 2001년에 우리에게 약속했던 그런 인공지능이 아니다”라고 설명했다. 칼럼은 주제의 선택과 편집까지 ‘인간’이 일을 도맡았고 사람의 결정과 입력이 없다면 칼럼 역시 없었을 거라고 밝혔다. GPT-3가 종말론을 불러올 만한 인공지능이 아니라 단순히 규칙들을 사용해 새로운 내용을 창조할 수 있는 문장 생성 엔진이라는 것이다. “마치 자동차의 크루즈컨트롤을 자율주행이라고 말하는 것과 같다”며 논란을 불식시키고 싶어 했다.

GPT-3는 자연 언어 처리에서 얼마나 많은 발전이 있었는지를 보여주는 대표 주자다. 인공지능 언어 생성에서 가장 큰 과제는 텍스트에서 일관성을 유지하는 일이다. GPT-3의 이전 모델인 GPT-2는 몇 문장만 작성해도 비논리적인 언급을 하며 일관성을 잃었다. 반면 GPT-3는 기계 학습 알고리즘을 통해 웹과 디지털화된 책에서 약 1조개의 단어를 수집해 통계적 표현을 찾는 엔진이다. 받아들인 텍스트 종류도 다양한데 각종 커뮤니티의 글부터 컴퓨터 언어인 C++ 튜토리얼까지 수많은 장르를 익혔다.

GPT-3는 이전 GPT-2보다 크게 확장시킨 인공신경망을 통한 딥러닝을 활용했는데 1750억개의 파라미터(매개변수)로 구성돼 있다. 입력한 텍스트 뭉치의 크기도 이전보다 크다. GPT-2보다 10배 이상 커진 450기가바이트의 텍스트로 학습했다. 인공신경망과 훈련 데이터가 커지면 네트워크의 성능은 향상된다. GPT-3가 이전 모델보다 일관성을 유지한 텍스트를 대량생산하는 데 능숙해진 이유다. 자신이 무슨 글을 쓰는지 이해하는 것보다는 기계학습을 통해 텍스트를 연결하는 영리한 방법을 알고 있다고 보는 편이 적합하다. 인공지능 전문가인 게리 마쿠스 뉴욕대 명예교수는 여러 번의 실험을 통해 “GPT-3는 단어들 사이의 상관관계를 배울 뿐, 그 이상은 배우지 않는다”고 결론 내렸다.

사람들은 전문가들의 이런 지적 속에서도 GPT-3, 혹은 GPT-3보다 발전한 모델이 가져올 미래의 모습을 그려보고 있다. 미국 IT 매체 ‘와이어드’에 소개된 프로그래머 샤리프 샤밈의 사례를 보자. 앱 제작 기업을 운영하는 그는 프로그램 코딩에 새로운 방법을 써보기로 했다. OpenAI는 GPT-3를 공개한 뒤 베타테스트 신청을 받았다. 이를 통해 베타테스터가 된 샤밈은 이 새로운 인공지능을 코딩에 활용해보기로 했다. 그는 할 일의 목록을 GPT-3에 지시했다. 몇 초 후 AI가 코드를 뱉어내기 시작했다. 샤밈은 결과물을 본 뒤 “등골이 오싹해졌다”면서 “뭔가가 우리와 다르다고 생각했다”고 말했다.

글 쓰는 인공지능 ‘GPT-3’가 쓴 소설. photo GPT-3 Creative Fiction 캡처

일반적 인공지능이라 무서운 GPT-3

GPT-3가 이전 인공지능과 다른 점은 ‘일반적’이라는 점이다. 우리가 아는 인공지능은 특정 과제에 맞춰 만들어진다. 알파고를 생각해보면 이해가 빠르다. 알파고는 오직 ‘바둑’이라는 반상 위에서만 적합한 AI였다. 이런 특정한 일을 하기 위해서는 특정 데이터 세트가 필요하지만 GPT-3는 특별한 목적에 맞춘 인공지능이 아니다. IT 전문매체 지디넷(zdnet)은 “특별한 데이터가 필요하지 않다는 건 텍스트가 필요한 어떤 분야에서도 결과물을 내놓을 수 있다는 걸 뜻한다”고 설명했다. 이렇게 ‘범용’에 가까운 인공지능은 상업적으로도 흥미로우며 사람들이 혹할 만한 소재다. GPT-3를 어떻게 코딩에 활용하는지 공개한 샤밈의 트윗은 무려 18만5000명 이상이 ‘좋아요’를 누르며 인기를 끌었다.

과열된 흥분을 누르기 위해 나선 사람은 GPT-3의 산파인 샘 알트만 OpenAI CEO였다. 그는 자신의 트위터에 “GPT-3에 대한 평가가 지나친 것 같다. 인상적일 순 있어도 약점을 가지고 있고 어리석은 실수도 한다”고 언급했다. 그의 말대로 베타테스트를 통해 한계점도 속속 발견됐다. 여전히 인간의 글쓰기 능력에는 미치지 못하며 텍스트가 길어질수록 일관성이 떨어지는 것도 이전보다는 개선됐지만 여전하다. 제롬 페센티 페이스북 AI 대표는 편견에 대한 약점을 지적하기도 했다. 그는 “GPT-3가 보이는 만큼 영리하지는 않다”며 인터넷의 어두운 면을 그대로 학습한 결과를 스크린샷으로 공개했다. 이 AI가 ‘유대인은 돈만 밝힌다’ ‘여성은 방향감각이 떨어진다’ 등의 표현을 쓰며 왜곡된 생산물을 내놓는다는 것이다.

이런 한계점이 등장했지만 GPT-3를 둘러싼 논쟁은 이 인공지능이 가지고 있는 시장성에 대한 기대로 모아지고 있다. 인공지능이 사람의 일을 대신할 수 있다는 건 비용절감이 가능하다는 뜻이고 결국 일자리 문제로 이어진다. 실제로 샤밈의 영상은 입소문을 타며 프로그래머들의 고용 전망에 대해서 우울한 예측을 불러왔다. GPT-3를 활용해 가계부를 작성하는 사람도 있었는데 이걸 좀 더 발전시키면 회계의 영역에도 GPT-3가 도입될 수 있다. 법률이나 회계와 관련한 규칙에 따라 텍스트를 수집하거나 요약하고 작성하는 데 인공지능을 활용하는 건 충분히 있을 법한 일이다.

창의적인 글쓰기를 해왔던 프로 작가들도 새로운 경쟁자를 맞을지 모른다. GPT-3가 어떤 종류의 글쓰기라도 할 수 있다는 점은 진짜 흥미롭다. 한 작가는 베타테스트를 통해 어니스트 헤밍웨이와 제인 오스틴의 스타일에 해리포터를 섞은 문학을 만들기도 했다. 특히 가디언의 사례에서 보듯 저널리즘은 가장 직접적인 영향을 받을 수 있는 산업이다. GPT-3와 같은 새로운 자연어 모델은 간단한 입력만 넣어주면 엄청난 데이터를 바탕으로 기자 대신 직관적인 기사를 생성해낼 수 있다. 우리는 이미 뉴스 큐레이션이나 주식 시황, 야구 경기 결과 등의 기사 작성을 인공지능으로 대체하는 매체들을 보고 있고, 그래서 이런 변화가 낯설지 않다.

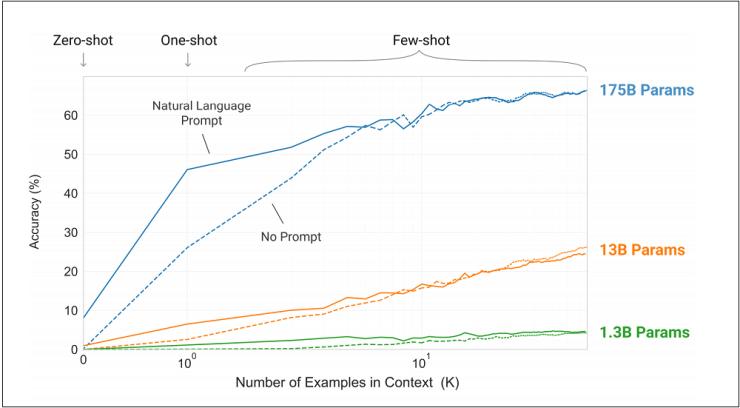

The researchers trained a series of smaller GPT-3 models The variations ranged from 125 million parameters to 1,300 million parameters. The accuracy gap between zero-shot, one-shot, and few-shot performance brodened with model parameter size. OpenAI researchers maintain that their research shows that yet larger models and more data input will be a successful path for adaptable, general language systems./s:techxplore.com

(연구원들은 일련의 더 작은 GPT-3 모델들을 훈련시켰다. 그 변화들은 1억 2천 5백만 매개변수에서 13억 매개변수까지 다양했다. 모델 매개 변수 크기와 함께 중첩된 제로샷, 원샷 및 노샷 성능 사이의 정확도 차이. OpenAI 연구원들은 그들의 연구가 더 큰 모델과 더 많은 데이터 입력이 적응 가능한 일반 언어 시스템의 성공적인 경로가 될 것이라는 것을 보여준다고 주장한다.)

edited by kcontents

인공지능이 쓴 글 뭉치가 무서운 이유

GPT-3가 보다 무서운 건 온라인 세계의 풍토 자체를 바꿔버릴 수 있어서다. 인공지능이 만들어낸 콘텐츠를 사람들이 알아채지 못해 생길 수 있는 부작용은 꽤 크다. 한때 딥페이크 영상이 이슈였던 때가 있었다. 인공지능 기술을 활용해 기존에 있던 인물의 얼굴이나 특정 부위를 합성한 영상인데 문제가 커지자 포털이나 보안 회사에서는 딥페이크를 찾아내는 기술 개발에 나섰다. 이것을 탐지할 수 있는 건 딥페이크는 합성의 밑그림이 되는 원본이 있기 때문이다. 반대로 GPT-3가 만들어낸 콘텐츠는 원본이 없다. 그 자체가 원본이라서다. 악의적으로 사용되더라도 사실 확인을 위한 근거로 찾아볼 만한 원재료가 없다. 감지할 수 없는 콘텐츠는 트위터나 페이스북, 커뮤니티 등을 통해 훨씬 널리 퍼질 수 있는데 이게 의도적이라면 문제가 커진다. 댓글이나 가짜뉴스라는 엄청난 글 뭉치들이 끼치는 사회적 영향력을 우리는 지금도 실감하며 살고 있다. 와이어드는 “우리가 인터넷에서 볼 수 있는 대부분의 텍스트 콘텐츠가 AI에 의해 만들어지는 미래를 상상할 수 있다. 만약 탐지가 어려워지면 우리는 우리가 보는 콘텐츠를 신뢰하기 점점 어려워질 것이다”라고 지적했다.

이런 우려가 지나친 걸까. 지난 8월 14일 기술 전문 잡지인 MIT테크놀러지리뷰는 “컴퓨터 과학을 전문적으로 다루는 ‘해커뉴스(Hacker News)’에 한 대학생이 작성한 기사가 1위에 올랐다”고 보도했다. 이 기사는 한 대학원생이 가짜 대학생을 내세워 GPT-3로 작성한 텍스트였는데 가디언 때와 달리 편집을 거의 하지 않고 그냥 복사해서 붙였다고 한다. 이 대학원생은 “이 기사를 읽은 수많은 사람 중에 작성자가 인공지능인 걸 의심하는 사람은 단지 한 명뿐이었다”라고 밝혔다. 기사 하단에 ‘이 기사는 인간이 작성했습니다’라는 문구가 필요한 세상이 올지도 모른다.

주간조선

GPT 3 Demo and Explanation - An AI revolution from OpenAI

kcontents